Livre blanc : Virtualisation

Virtualisation de serveurs et surveillance réseau

Introduction

La virtualisation de serveurs est actuellement la tendance la plus importante concernant les technologies pour les centres informatiques.

Gartner prévoit que la virtualisation aura l'influence la plus grande concernant la TI au niveau opérationnel:

www.gartner.com/it

Gartner prévoit que la virtualisation jusque 2012 de toutes les nouvelles technologies aura l'influence la plus grande concernant la TI au niveau opérationnel comme celui des infrastructures. Malgré toutes les limites, si la virtualisation de serveurs est utilisée avec succès, elle a un effet très positif non seulement sur les coûts d'énergie mais aussi sur la capacité des centres informatiques. La virtualisation des serveurs peut prolonger la durée de vie des plus vieux centres informatiques et pour les grandes entreprises ayant plusieurs centres informatiques, elle peut sous certaines conditions économiser des centres informatiques complets.

Et ce n'est que le début de possibilités qui sont offertes par la première génération des technologies de la virtualisation de serveurs. Une deuxième génération permettant l'utilisation de multiples serveurs virtuels avec une seule licence du système d'exploitation promet une consolidation plus élargie. Cette 2ème génération va si loin que de 50 à 100 serveurs virtuels peuvent opérer sur un seul ordinateur physique pouvant gérer des applications avec des calculs tellement intensifs que la première génération de virtualisation ne peut pas encore y penser.

La virtualisation libère les applications des limites qu'un seul serveur physique leur impose. Elle permet l'opération de plusieurs applications sur un serveur ou sur une série entière de serveurs et ainsi, elle trouve pour une application les ressources de tout le réseau.

L'une des perspectives de la virtualisation est la possibilité d'un passage dynamique des applications d'un serveur à l'autre selon les exigences et les ressources disponibles sans que le serveur soit interrompu. Pour pouvoir opérer la virtualisation d'une application (ce qui correspond souvent à un serveur virtualisé) sur divers serveurs hôtes, il est nécessaire d'utiliser des SANs (Storage-Area Networks) - qui transmettent les donnés dans le réseau - en tant que solution de sauvegarde. Ainsi les réseaux reviennent au centre des infrastructures de l'architecture de la TI.

Concernant l'aspect sécurité, la concentration de multiples applications sur un seul ordinateur séparé provoque des points de risques centraux non seulement à cause du serveur physique mais aussi à cause de sa connexion de réseau. Si un serveur hôte pose problème, sa connexion de réseau va ralentir ou même s'interrompre et tous les services virtualisés sur cet hôte seront affectés immédiatement.

Pour la planification du réseau cela signifie que le trafic réseau se concentre sur un petit nombre de grands serveurs au lieu d'être distribué sur beaucoup de petits ordinateurs du centre informatique.L'opération de la virtualisation est souvent beaucoup plus efficace avec les seules solutions de sauvegarde (SAN) qu'avec les solutions « Attached-Storage ». Mais l'opération avec SAN requiert des connexions de réseau très rapides et fiables entre les serveurs et les supports d'enregistrement. Les entreprises qui changent de solution dans le cadre de la virtualisation « Attached-Storage » pour des SAN, y génèrent une énorme augmentation de leur trafic réseau.

Tout cela requiert une surveillance conséquente du réseau. Un environnement hautement virtualisé dépend entièrement de l'efficacité et de la fiabilité de son réseau. Des défaillances de serveurs physiques, de connexions, de Switch ou de routeurs peuvent coûter chers, si à cause de cela les collaborateurs, les chaînes de production automatisées ou les boutiques en ligne n'ont plus accès aux fonctionnalités TI indispensables pour les affaires.

La surveillance réseau peut fournir des informations cruciales pour la planification et le test sur les environnements virtualisés. Ainsi il est par exemple essentiel de savoir quelles applications ne sont pas qualifiées pour une virtualisation. Le volume et la nature du trafic réseau peuvent fournir des indications importantes pour identifier ces applications.

Les raisons pour la virtualisation de serveurs

Que la technologie de la virtualisation de serveurs se soit entretemps développé au stade « adulte », arrive à point pour les entreprises et les départements TI qui subissent la pression de coûts. Dans l'optique d'une récession mondiale qui se prépare, avec des coûts énergétiques qui augmentent en permanence et un grand nombre de centres informatiques qui atteignent leurs limites, elle offre une possibilité décisive pour économiser des coûts informatiques.

La virtualisation peut aussi résoudre le problème des serveurs sous-utilisés, ce qui apparaît toujours plus souvent dans les centres informatiques des moyennes et des grandes entreprises. Les serveurs de beaucoup d'environnements non virtualisés ont souvent une charge moyenne de moins de 20%. Il en résulte un énorme gaspillage de l'énergie qui est presque doublé car chaque kilowatt utilisé produit de chaleur, qui à son tour nécessite une réfrigération correspondante pour générer la température d'opération adéquate pour les serveurs.

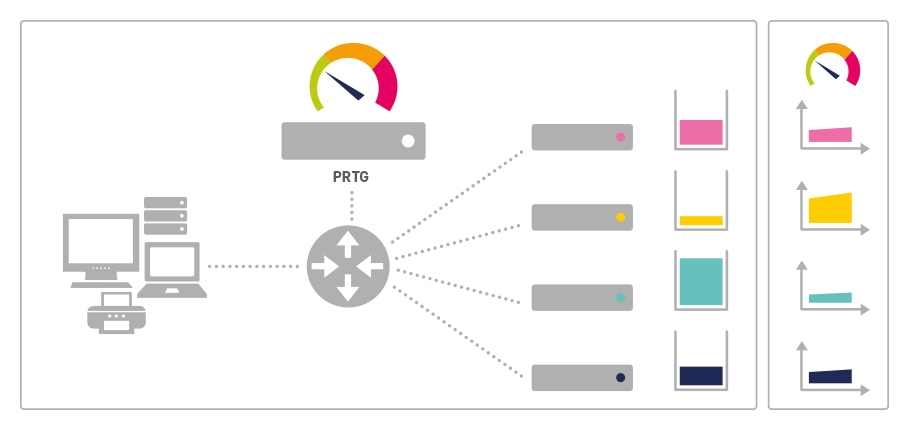

Environnement distribué

ILLUSTRATION: Chaque application se trouve

sur un serveur physique séparé

avec « attached storage

» (= le stockage en pièce jointe)

Cela a des conséquences sérieuses sur la durée de vie des centres informatiques car toujours plus d'entreprises doivent économiser sur l'énergie, sur la réfrigération et souvent déjà sur l'espace. La virtualisation empêche ce problème en automatisant la gestion de plusieurs applications sur un serveur et sur la diffusion des ressources disponibles. Ainsi les départements TI peuvent augmenter la charge de serveur jusqu'à 80%.

Le sens concret de cet effet pour les grandes entreprises est montré par l'exemple de l'entreprise britannique « BT ». Ce prestataire de communication global a pu, grâce à une virtualisation conséquente, réduire de 15 fois ses 3.000 serveurs Wintel et ainsi économiser approximativement 2 Mégawatt de courant et 2,4 Millions de US Dollars. Les coûts pour la maintenance des serveurs ont été baissés de 90%, un équipement de 225 tonnes a été recyclé (écologiquement) et plusieurs centres informatiques dans toute la Grande-Bretagne ont pu être économisés.

Ces économies sont d'autant plus remarquables que l'on a seulement pris en compte les serveurs Wintel - BT opère en plus avec un grand nombre de serveurs Unix qui n'ont pas été considérés lors du calcul des économies. Ainsi, BT n'a pas seulement réduit significativement les coûts actuels (entre autres, la construction d'un nouveau centre informatique de 120 Millions US$ budgétisés a pu être évitée) mais on lui a décerné trois prix d'écologie européens importants concernant la réduction de la production du dioxyde de carbone.

Pendant le processus complet, BT a connu une croissance constante. Cela réfute l'argument souvent utilisé sur les entreprises qui devraient choisir entre la croissance et l'écologie. Sans la moindre perte pour les affaires, ce projet a consolidé le concept d'une direction d'entreprise « verte » qui a été introduit dans l'UE et aux USA au début cette décennie. Et ceci est seulement un petit exemple de réussite, comparé à ce que la virtualisation de serveurs peut atteindre.

BT est une très grande entreprise. Il se peut que les plus petites entreprises enregistrent proportionnellement moins d'économises mesuré en chiffres absolus. Les pourcentages sont cependant complètement réalistes pour des entreprises avec plus de 50 serveurs.

Ainsi, elles peuvent prolonger efficacement la durée de vie de leurs centres informatiques et aussi les coûts d'énergie.

Des économies par la virtualisation chez BT en Grande-Bretagne:

http://wikibon.org

Mais les entreprises encore plus petites peuvent également bénéficier de la virtualisation, surtout si elles ont besoin de mettre à jour un serveur. Un plus grand serveur cause moins de coûts lors de l'acquisition, l'opération et la maintenance qu'un plus faible nombre de petits serveurs. L'automatisation de la gestion des différentes applications qui est effectuée par la virtualisation, peut nettement soulager le personnel des petites entreprises.

Les économies précitées sont atteintes entre autres par l'utilisation de la technologie dénommée « Hypervisor » lors de la virtualisation. Cette technologie Hypervisor est utilisée par les produits VMWare Server, Microsoft Virtual Server, XenServer et des produits similaires. La technologie Hypervisor a besoin d'une seule copie du système d'exploitation pour chaque serveur. Cette solution est préférée si les applications présentes sur différentes exploitations de système - comme p.ex. Windows, Unix ou Linux - doivent être opérées comme des applications virtualisées sur un ordinateur physique, c'est-à-dire chaque ordinateur virtuel pense qu'il a le matériel pour lui-même.

Mais il y des solutions plus efficaces, quand des applications différentes, qui sont présentes sous le même système d'exploitation, doivent être virtualisées. Dans ce cas, la virtualisation des applications (contrairement à la virtualisation de serveur) est une solution nettement plus efficace qui permet l'utilisation d'une seule copie de l'exploitation de système (p.ex. avec Virtuozzo, OpenVZ) pour plusieurs applications virtuelles. Au fur et à mesure de l'application, des applications hautement performantes qui ne se prêtent pas à la virtualisation à l'aide de la technique Hypervisor, peuvent être aussi virtualisées.

La surveillance réseau et la virtualisation

Il apparaît à première vue que la virtualisation a peu de conséquences sur la gestion de réseau. Les mêmes applications circulent toujours dans les mêmes centres informatiques, seulement sur un autre appareil. Quand on y regarde de plus près, des conséquences apparaissent sur la gestion de réseau. L'importance de ces conséquences dépend hautement de l'architecture de la virtualisation. Une vaste virtualisation est l'une des nombreuses causes pour le remplacement des systèmes informatiques centraux par le réseau comme centre de l'infrastructure TI.

Cela augmente l'importance de l'opération du réseau ainsi que les conséquences potentielles des pannes et fait d'une surveillance du réseau conséquente une nécessité essentielle pour les entreprises innovatrices.

La virtualisation dans la pratique

La concentration des applications

La virtualisation guide les applications ensemble sur un ou quelques serveurs physiques peu nombreux et produit ainsi des points de risque centraux. Des perturbations des serveurs restants ou de leurs connexions réseau peuvent avoir comme conséquence des perturbations massives pour l'entière opération des affaires. Qui se souvient des années 1980 et des terminaux utilisés à cette époque, sait, que la panne d'un ordinateur central peut paralyser complètement une entreprise. La panne d'un Switch ou d'un routeur dans un environnement hautement virtualisé peut avoir des conséquences similaires en interrompant l'accès à 50 ou 100 applications centrales.

Une solution de surveillance réseau comme p.ex. le PRTG Network Monitor de Paessler, réagit immédiatement aux moindres petits changements dans le trafic réseau ainsi qu'aux dysfonctionnements des appareils ou des applications et peut ainsi alerter immé- diatement le responsable département TI en cas de pannes d'un serveur Windows ou de ses connexions réseau, de sorte que le département peut réagir tout de suite et peut éviter des conséquences plus graves.

Les solutions de sauvegarde lors de la virtualisation

La virtualisation de serveurs permet de partager et de déplacer dynamiquement les ressources comme p.ex. la mémoire de disque dur entre les différentes applications selon la demande. Un environnement avec des serveurs différents a exigé une migration des solutions Attached Storage (les serveurs disposent de propres disques durs comme les ordinateurs fixes ou portables) vers des systèmes avec des supports d'enregistrement, les dénommés SANs (Storage-Area Networks) appartenant à une vaste infrastructure de réseau.

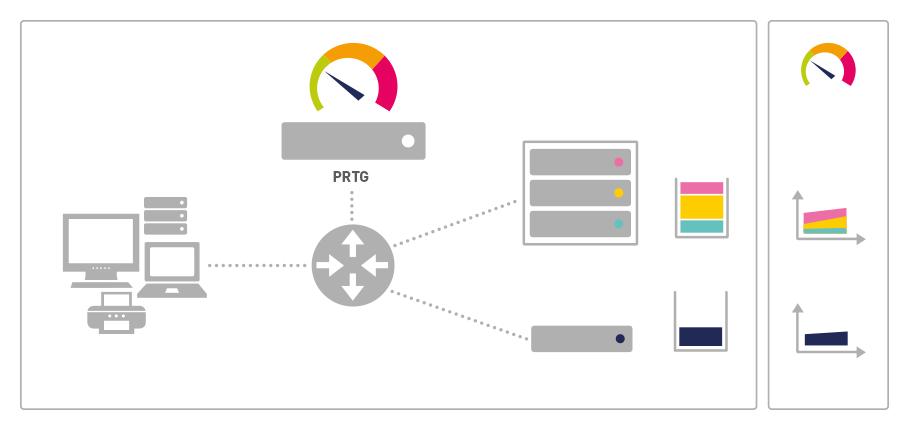

Consolidé par la virtualisation

ILLUSTRATION: Trois applications fonctionnent

dans un environnement virtuel

en partageant les ressources

du serveur virtualisé

Cette migration se produit depuis la fin des années 1990 et apporte des avantages variés quant à la flexibilité et la sécurité de données. Elle va encore s'accélérer, après que la virtualisation aura atteint les entreprises qui utilisent encore des applications avec des

solutions Attached Storage. L'inconvénient est que tout le trafic de données des applications s'effectue par le réseau et les plus petits ralentissements lors des applications peuvent déjà causer des problèmes.

Par conséquent, les environnements virtualisés ne peuvent que difficilement tolérer des pannes de Switch ou des surcharges du réseau. Dans ce contexte, les solutions de surveillance réseau fiables comme celle de PRTG Network Monitor, sont exigées, car elles surveillent non seulement les points critiques d'un réseau en temps réel mais elles identifient aussi les tendances à long terme à l'aide de données historiques. Ainsi, les responsables réseau peuvent planifier en avance et éviter à temps les goulots d'étranglement.

Les applications non qualifiées pour la virtualisation

Les applications intensives en calcul et en mémoire s'avèrent de mauvaises candidates pour la virtualisation sous la technologie Hypervisor. Par conséquent, une virtualisation générale peut mener à des problèmes sérieux en ce qui concerne le respect des qualités de service. Cependant, il n'est pas toujours facile d'identifier des applications qui devraient fonctionner mieux sur un serveur Dedicated. La nature et le volume du transfert de données d'une application à l'autre fournissent des indications cruciales. Les données de surveillance précises sont la base de l'identification de ces applications.

La virtualisation et la gestion de ressources

La virtualisation de serveurs promet l'attribution dynamique du travail de calcul et de l'espace de mémoire pour pouvoir intercepter les pics de consommation des seules applications. Cela permettrait une utilisation nettement plus efficace des ressources existantes. L'une des raisons principales pour le bas niveau d'utilisation des environnements non virtualisés est qu'on doit disposer de ressources suffisantes (capacité de calcul, mémoire de travail et de disque dur) pour chaque application, pour intercepter les pics de demandes y compris une réserve pour une augmentation probable des demandes.

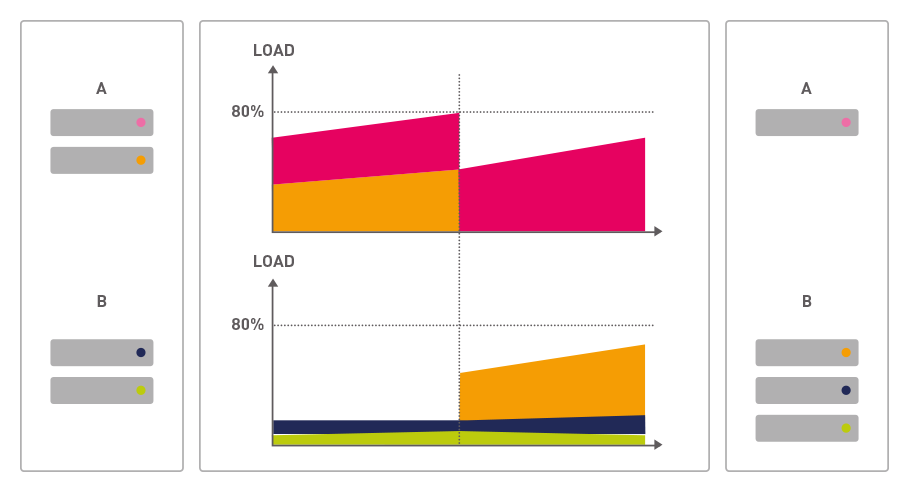

Load Balancing (La répartition de charge)

ILLUSTRATION: Avec une acceptation

d'utilisateur croissante

une nouvelle application

(en rouge) peut exiger

plus de ressources. Cela

peut être facilement

réalisé à tx en déplaçant

une application (en bleu)

sur une autre machine virtuelle

Il est souvent difficile de prévoir à l'avance cette augmentation des demandes. On peut souvent ici s'attendre à une hausse exponentielle plutôt qu'à une courbe douce: aussi longtemps que les collaborateurs doivent se familiariser avec une nouvelle application, son utilisation est souvent très réduite. Mais quand les collaborateurs ont reconnu l'utilisation de cette application, pour leur travail, cette application est utilisée massivement.

Beaucoup d'applications subissent des cycles d'utilisation avec des oscillations fortes, qui peuvent avoir lieu dans un rythme hebdomadaire, mensuel ou annuel. Les logiciels financiers sont un exemple typique d'application qui est soumise à un fort cycle mensuel ou trimestriel. De plus, il y a beaucoup d'autres d'applications qui ne sont pas utilisées régulièrement.

Dans un environnement non virtualisé, on doit disposer en permanence de ressources complètes pour un niveau d'exigence maximal en raison ces oscillations. Cela peut mener à d'énormes investissements en travail de calcul ou en mémoire qui sont ensuite inexploités. La virtualisation résout ce problème en assignant dynamiquement les ressources à chaque application. Le besoin des seules applications dans un centre informatique passe habituellement par des cycles différents.

Une application peut en cas d'un effort plus important « louer » les ressources d'une autre application qui sont moins utilisées au même moment.Dans les cas exceptionnels, les environnements virtualisés doivent pouvoir déplacer des applications entières d'un serveur à l'autre sur le réseau pour atteindre ces exigences. Cela mène en dernier ressort au fait que tous les serveurs et supports d'enregistrement pourront être traités comme un seul grand ordinateur dans un environnement virtualisé. Toutes les ressources pourront être additionnées et déduites de la somme des exigences de toutes les applications.

Dans la pratique, cela fonctionnera seulement dans un seul centre informatique car les plus petites pertes de vitesse de la connexion peuvent déjà mener à des réductions de performance. En outre, cela peut seulement fonctionner tant que le réseau qui connecte

les serveurs physiques est rapide et hautement tolérant à des pannes. Pour garantir la performance nécessaire, une gestion et surveillance professionnelle du réseau sont par contre nécessaires.

La virtualisation et les logiciels de Paessler

La société Paessler AG dont le siège se trouve à Nuremberg offre avec PRTG Network Monitor une vaste solution pour la surveillance des réseaux de toutes dimensions. PRTG Network Monitor couvre tous les aspects d'une surveillance réseau professionnelle: la surveillance de la disponibilité, la mesure de la bande passante et de l'utilisation, SNMP, NetFlow, WMI, Packet Sniffing et beaucoup plus, combinée avec des vastes fonctionnalités d'analyse et de présentation.

Pendant l'étape de la planification de la virtualisation, PRTG Network Monitor peut déjà donner des éclaircissements sur des demandes de performance présumées. Elle permet à l'applicateur de faire des suppositions sur les pics de charge présumés et ainsi elle permet la planification des ressources nécessitées selon les demandes.

Pendant l'opération, PRTG garantit la surveillance sans niche des environnements virtuels en temps réel. Les risques se formant à cause de la concentration des applications centrales sur un petit nombre de serveurs physiques sont contrôlés en permanence, de sorte qu'on peut réagir immédiatement en cas de pannes ou de perturbations et des conséquences graves peuvent être ainsi évitées. A l'aide des évaluations des données de surveillance à long terme, on peut découvrir des points faibles et ainsi, on peut éviter des pannes et améliorer la performance générale.

Le PRTG Network Monitor convainc, en plus de son offre large de fonctionnalités de surveillance, par son installation facile avec l'identification réseau automatique, par sa configuration facile, ainsi que par une utilisation intuitive et conviviale et par une haute

performance et enfin, par un excellent rapport qualité-prix. Dans le monde entier, sont utilisées pas moins de 500 000 installations de PRTG. A côté de PRTG Network Monitor, la société Paessler AG offre avec Webserver Stress Tool un autre produit qui peut être utilisé comme soutien lors de la planification et l'optimisation des environnements virtualisés.

Le Webserver Stress Tool est un logiciel de test pour les serveurs http (serveurs Web) qui découvre les problèmes cachés se formant lorsque les serveurs ou applications Web sont trop chargés. Par la simulation de centaines et de milliers d'utilisateurs qui envoient simultanément des demandes http à un serveur, on peut tester le comportement d'un serveur Web en charge normale et extraordinaire et ainsi, on peut calculer et mettre à disposition les ressources nécessaires.

Le PRTG Network Monitor et le Webserver Stress Tool sont disponibles en version freeware, en version de test de 30 jours et en différentes versions commerciales sur www.paessler.com/fr.